Knowledge: Thách thức và giới hạn của AI Agents

V-1 Thách thức và Giới hạn của AI Agents

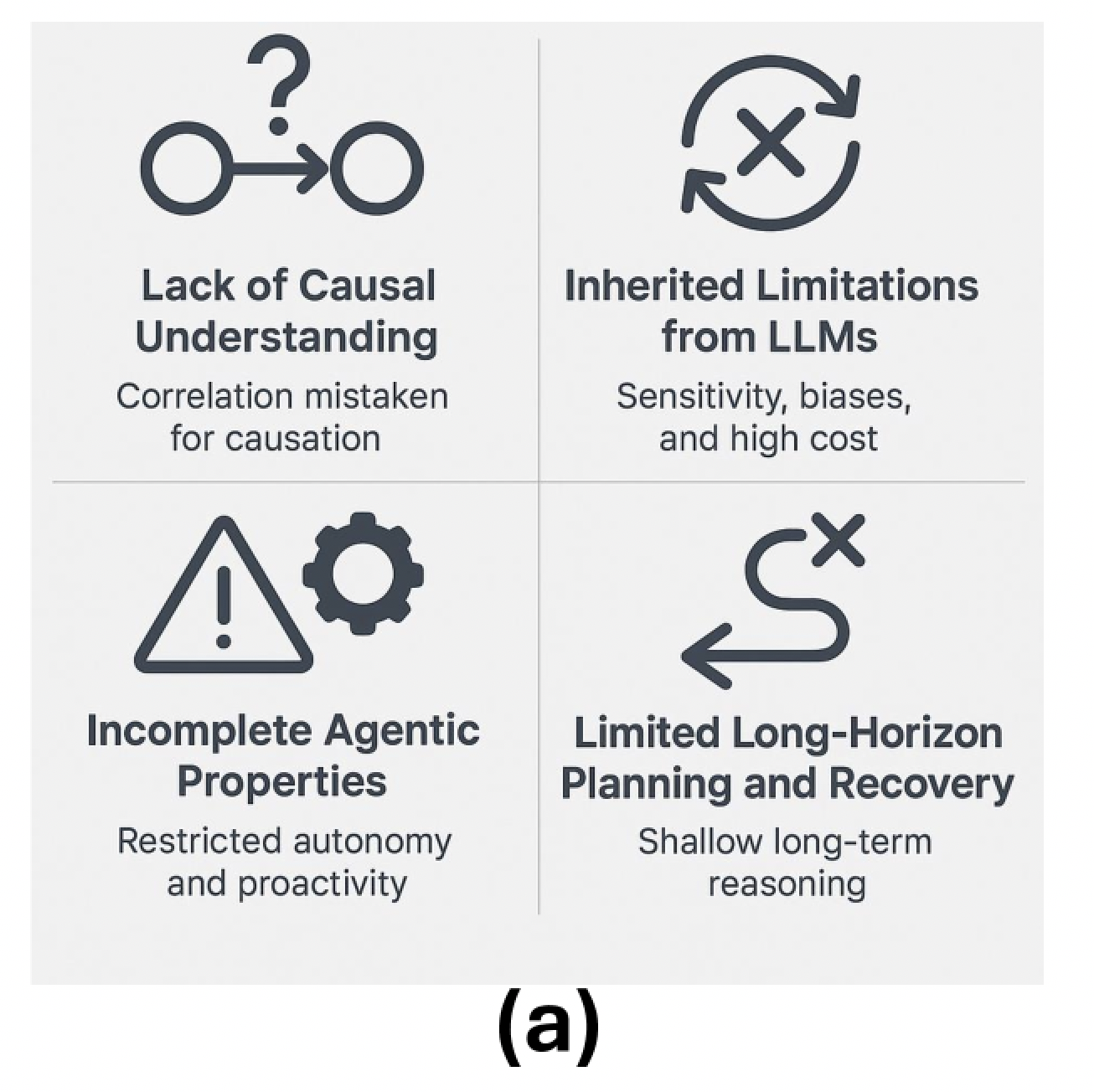

AI Agents dù được đánh giá cao về khả năng tự động hóa các tác vụ có cấu trúc bằng LLM và công cụ hỗ trợ, nhưng hiện nay vẫn còn nhiều giới hạn lý thuyết và thực tiễn làm giảm độ tin cậy, khả năng tổng quát và tính tự chủ dài hạn. Những giới hạn này xuất phát từ việc dựa quá nhiều vào các mô hình tĩnh (pretrained) và khó tích hợp các năng lực agentic như suy luận nhân quả, lập kế hoạch và thích nghi linh hoạt.

| # | Thách thức | Mô tả |

|---|---|---|

| 1 | 🔗 1. Thiếu khả năng suy luận nhân quả <img  |

- Các LLM hiện nay giỏi tìm ra mối tương quan thống kê nhưng không hiểu được quan hệ nhân quả. - Không thể phân biệt giữa “đi viện ↔ bị bệnh”: bệnh gây ra việc đi viện hay ngược lại? - Khi môi trường thực tế khác với dữ liệu huấn luyện (distribution shift), agent dễ thất bại. - Ví dụ: Agent điều hướng hoạt động tốt ở thành phố nhưng sẽ lỗi trong khu vực có tuyết hoặc công trường nếu không có hiểu biết về điều kiện đường trơn trượt. |

| 2 | 🤖 2. Kế thừa hạn chế từ LLM <img  |

- Hallucination: Agent có thể tạo ra kết quả trông hợp lý nhưng sai sự thật. - Nhạy cảm với prompt → chỉ cần thay đổi nhỏ trong cách đặt câu hỏi cũng cho kết quả khác. - Các kỹ thuật Chain-of-Thought (CoT) hay ReAct chỉ mô phỏng suy luận, chưa thật sự hiểu sâu. - Chi phí tính toán cao → mỗi quyết định có thể cần gọi LLM nhiều lần → tăng độ trễ, tốn tài nguyên. - LLM có kiến thức tĩnh (không cập nhật theo thời gian), dễ mang thiên kiến từ dữ liệu huấn luyện. |

| 3 | 🧩 3. Thiếu đặc tính agentic hoàn chỉnh <img  |

- Các hệ thống hiện nay chưa thỏa mãn đầy đủ các đặc tính như: - Tự chủ: vẫn phụ thuộc nhiều vào prompt định sẵn, hiếm khi tự đặt mục tiêu hay tự sửa lỗi. - Chủ động: ít hệ thống nào có thể tự thay đổi mục tiêu khi hoàn cảnh thay đổi. - Phản ứng: bị giới hạn bởi độ trễ do phải gọi LLM liên tục, vùng nhớ ngắn. - Giao tiếp xã hội: chưa có khả năng tương tác dài hạn, nhớ ngữ cảnh, trao đổi linh hoạt với người dùng hoặc các agent khác. |

| 4 | 🧭 4. Hạn chế trong lập kế hoạch dài hạn và phục hồi lỗi <img  |

- Phần lớn AI Agent hiện chỉ hoạt động theo vòng lặp prompt → phản hồi, không có trạng thái nội tại. - Các phương pháp như ReAct, Tree-of-Thought chỉ là heuristic, không thật sự hiểu thời gian, nguyên nhân – hệ quả. - Khi subtasks bị lỗi, agent thường lặp lại thao tác, không biết phục hồi hoặc chuyển hướng. - Thiếu cơ chế phát hiện lỗi và tái lập kế hoạch → workflow dễ hỏng. |

| 5 | 🛡 5. Rủi ro về độ tin cậy và an toàn <img  |

- AI Agents chưa đủ an toàn để triển khai trong các hệ thống quan trọng. - Không có khả năng suy luận nhân quả → hành vi dễ không ổn định khi gặp điều kiện lạ. - Chưa có cách đánh giá đúng sai các bước trung gian mà agent tạo ra. - Các hệ thống hiện tại chủ yếu dựa vào prompt thủ công dễ vỡ. - Muốn vượt giới hạn này, cần: - Mô hình nhân quả - Bộ nhớ động - Cơ chế lập luận có thể kiểm chứng |

✅ Tổng kết

- AI Agents hiện nay thiếu suy luận nhân quả, chưa thật sự tự chủ, lập kế hoạch còn yếu, và chưa có cơ chế an toàn rõ ràng.

- Đây chính là lý do dẫn tới sự ra đời của Agentic AI – khắc phục các điểm yếu bằng:

- Nhiều agent hợp tác (multi-agent)

- Tầng điều phối (orchestration)

- Bộ nhớ dài hạn (persistent memory)

- Năng lực lập luận mạnh hơn (verifiable reasoning)

Refer: https://arxiv.org/html/2505.10468v1#S3

Tiếp theo:

- http://mikesholic.com/knowledgeai/2025/10/12/AI_Agentic_Summary.html

- http://mikesholic.com/knowledgeai/2025/10/12/LLM-based-Multi-Agents(LLM-MA).html

- http://mikesholic.com/knowledgeai/2025/10/12/Challenges-Agentic-AI.html

- http://mikesholic.com/knowledgeai/2025/10/12/Solution-AI-Agent-Agentic.html